Artikel • Digitale Assistenzsysteme

Navigation im OP der Zukunft

„Digitalisierung und maschinelles Lernen halten auch in der Chirurgie Einzug“, sagt Stefanie Speidel, Professorin für Translationale Chirurgische Onkologie am NCT Dresden. Auf dem Deutschen Röntgenkongress spricht sie über die Möglichkeiten digitaler OP-Assistenzsysteme und die Voraussetzungen für deren Einsatz.

Bericht: Wolfgang Behrends

„Das Ziel ist ein vernetzter Operationssaal, in dem alle Datenströme in Echtzeit analysiert und für Assistenzsysteme genutzt werden können.“ Digitale Helfer können hier als Navi fungieren, das den Chirurgen während des Eingriffs über die Lage wichtiger Strukturen wie Tumoren oder Gefäße informiert. Das erhöht Sicherheit und Präzision der Eingriffe und verkürzt deren Dauer.

Im „OP 4.0“ ist alles verbunden

Es ist wichtig, dass nicht nur Informatiker, sondern auch Chirurgen selbst an der Entwicklung dieser Technologien beteiligt sind, denn sie sind es, die die Systeme später einsetzen

Stefanie Speidel

Fundament dieser Technik ist ein Netz aus miteinander verbundenen Geräten, die einen stetigen Datenstrom erzeugen. „Parallel zur Industrie 4.0 könnte man hier auch vom ‚OP 4.0‘ sprechen“, so Speidel. Neben Echtzeit-basierten Positionsdaten werden auch vorher erhobene Patienteninformationen wie Bildgebung oder Laborwerte in den Datenstrom einbezogen, so dass aus all diesen Daten kontext-sensitive Handlungsempfehlungen abgeleitet werden. „Gleicht man den aktuellen Verlauf darüber hinaus mit historischen Daten ab, lassen sich sogar bevorstehende Komplikationen vorhersagen.“ Auch die voraussichtliche Restdauer eines Eingriffs lässt sich berechnen – das hilft etwa dem Anästhesisten bei der richtigen Dosierung oder dem Klinikmanagement bei der Koordination nachfolgender Eingriffe.

Damit alle in diesem Netzwerk die gleiche Sprache sprechen, ist die Etablierung von Standards entscheidend. Einen wichtigen Schritt in diese Richtung hat das vom Bundesministerium für Bildung und Forschung (BMBF) geförderte „OR.net“-Projekt beigetragen, bei dem etwa die Norm ISO/IEEE 11073 zum Datenaustausch zwischen Medizingeräten festgelegt wurde. „Es ist wichtig, dass nicht nur Informatiker, sondern auch Chirurgen selbst an der Entwicklung dieser Technologien beteiligt sind, denn sie sind es, die die Systeme später einsetzen“, betont Speidel.

Lernende Systeme greifen dem Menschen unter die Arme

© NCT Dresden/André Wirsig

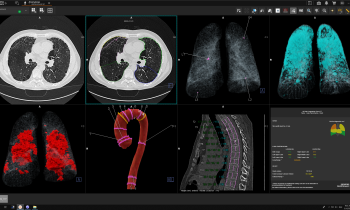

Ein Navi funktioniert nicht ohne zuverlässiges Kartenmaterial, das gilt sowohl auf der Straße als auch im OP. Prä-operative Aufnahmen aus CT oder MRT dienen als Grundgerüst für die Orientierung im Patienten. Diese Bilddaten müssen so aufbereitet werden, dass das Assistenzsystem etwas damit anfangen kann. Bereits an diesem Punkt greift ein Algorithmus dem Menschen unter die Arme: „Der Radiologe annotiert auf einer Aufnahme die relevanten Punkte – wo sich ein Tumor befindet und wo gesundes Gewebe – und der Computer weitet diese Segmentierung selbstständig auf weitere Schichten dieser Aufnahme aus.“ Diese Aufgabe, die sich bislang Mensch und Maschine teilen, könnte dank Deep Learning schon bald ganz in der Hand des Algorithmus liegen und so den Arzt weiter entlasten, ist die Expertin überzeugt.

Zur genauen Bestimmung der eigenen Position umfasst das Assistenzsystem ausgeklügelte Tracking-Mechanismen. „Das funktioniert über kleine Kügelchen, die an den Instrumenten angebracht sind.“ Ein Sensor erkennt diese Markierungen und weiß so jederzeit, wo sich das Instrument gerade befindet. Spezielle Oberflächenscans helfen, die Aufnahmen aus der Bildgebung mit der Realität im OP in Einklang zu bringen.

© KIT

Das Problem der „elastischen Karte“

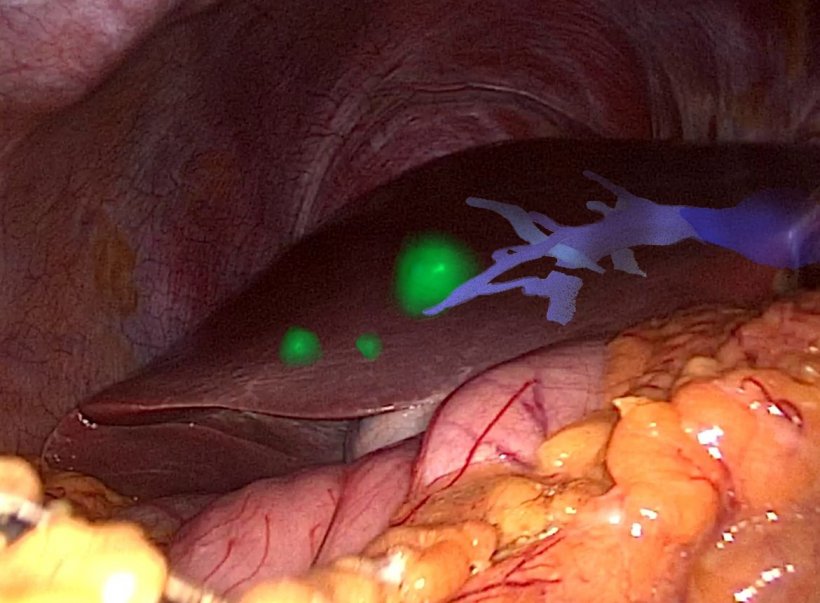

Die vom Algorithmus erstellte individuelle Karte der Zielstruktur kann in eine Datenbrille oder ein Laparoskopiebild eingebunden werden – diese sogenannte Erweiterte Realität (augmented reality) ermöglicht es dem Operateur, schon vor einem Eingriff zu sehen, wie ein Organ im Inneren aussieht. Das funktioniert noch nicht überall reibungslos. Bislang ist etwa die Viszeralchirurgie außen vor, denn dort stellt das Weichgewebe die Entwickler vor besondere Herausforderungen: „Die Lage der Strukturen verändert sich ständig – durch Atmung und Herzschlag des Patienten oder sobald eine Interaktion stattfindet, beispielsweise ein Schnitt gemacht wird“, erklärt Speidel. „Man benötigt daher eine elastische Karte, die sich bei jeder Verformung in Echtzeit anpasst.“ Das setzt sehr leistungsstarke Computer und ausgeklügelte Algorithmen voraus, denn von den von außen sichtbaren Bewegungen muss der Algorithmus auf die Veränderungen im Inneren schließen.

Aktuelle Systeme sind noch nicht zuverlässig in der Lage, diese Deformationen vorherzusagen. In Bereichen, in denen weniger Bewegung vorherrscht, kommen die Navigationssysteme dagegen bereits zum Einsatz – etwa in der Orthopädie oder der Neurochirurgie: „Dort geht es vor allem um knöcherne Strukturen, die sich nicht deformieren, deshalb gibt es bereits kommerzielle Lösungen, die praktisch eingesetzt werden.“ Bis die Assistenzsysteme auch mit beweglichen Strukturen gut zurechtkommen, ist noch einiges an Forschungsarbeit nötig, so die Expertin.

Auf dem Holodeck für den Eingriff üben

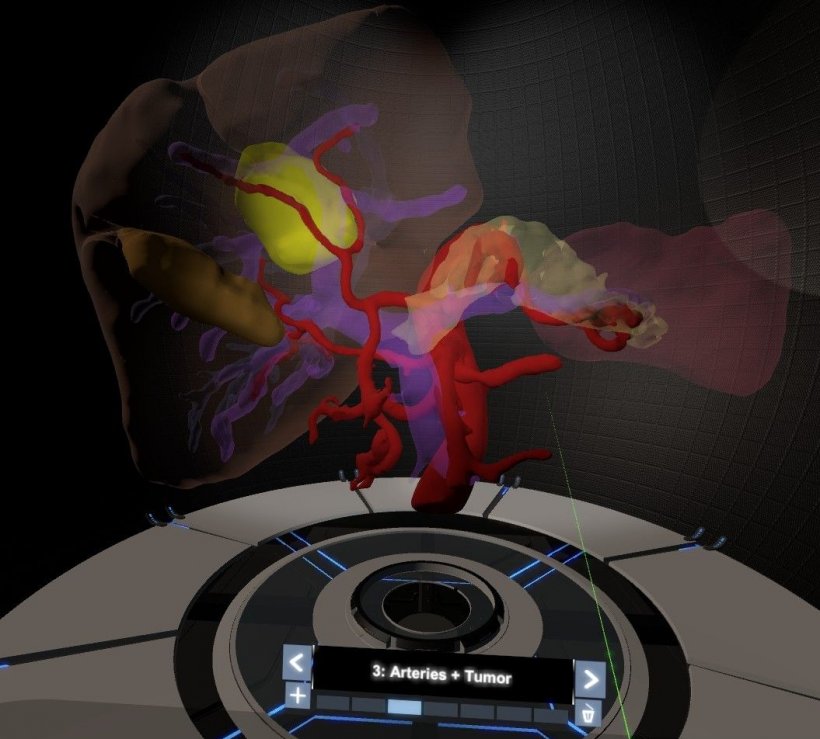

Die Technik hat auch großes Potenzial für die Vorbereitung und Ausbildung. „In einer virtuellen 3D-Umgebung können Chirurgen die Daten des Patienten aus der präoperativen Bildgebung nutzen, um sich auf komplexe Eingriffe vorzubereiten. Auch für Medizinstudenten ist eine ganze Reihe an Simulationen möglich.“ Von vergleichsweise einfachen Anatomie-Vorführungen bis hin zu komplexen Situationen im Schockraum mit mehreren gleichzeitig agierenden Akteuren lassen sich viele Szenarien darstellen, sagt Speidel.

Dieser Artikel könnte Sie auch interessieren

Video • Virtuelle Reality

VR bietet mehr als ‚hübsche‘ Radiologie-Aufnahmen

Virtual Reality (VR) in der Medizin ist keine Spielerei, sagt Prof. Dr. Philippe C. Cattin, Leiter des neugegründeten Department of Biomedical Engineering (DBE) der Universität Basel in der Schweiz. Zusammen mit dem Universitätsspital Basel will der Computerwissenschaftler diese These ganz praktisch belegen und hat verschiedene Studien angestoßen, um den medizinischen Mehrwert von VR-Software…

Profil:

Stefanie Speidel ist Professorin für Translationale Chirurgische Onkologie am Nationalen Centrum für Tumorerkrankungen (NCT) in Dresden. Nach ihrem Studium an der Universität Karlsruhe (TU) sowie am Royal Institute of Technology Stockholm (Schweden) forschte sie als Postdoktorandin an der Universität Heidelberg und leitete seit 2012 eine eigene Nachwuchsgruppe, „Computer assisted Surgery“, am Karlsruher Institut für Technologie (KIT). Stefanie Speidel konnte bereits eine Reihe wissenschaftlicher Auszeichnungen sammeln, darunter den Technology Award der European Association for Endoscopic Surgery (2007), den Maria Gräfin von Linden Preis (2011) und ein Margarete-von-Wrangell-Fellowship (2011). Außerdem wurde sie bereits mehrfach für hervorragende Lehre ausgezeichnet.

29.05.2019