Video • EEG vs fMRI

Algorithmus erkennt, wie wir Gesichter wahrnehmen

Mittels EEG-Daten wird nachgebildet, wie wir Bilder verarbeiten

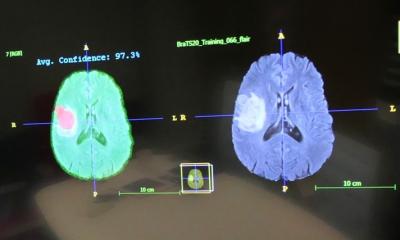

Forscher der University of Toronto haben eine Technologie entwickelt, die abbildet, was eine Person wahrnimmt. Mithilfe der Gehirnaktivität, die mittels Elektroenzephalografie (EEG)-Daten ermittelt wird, gelingt die Rekonstruktion der Bilder. Im Vergleich zur funktionellen Magnetresonanztomografie (fMRI), die in früheren Versuchen zum Einsatz gekommen ist, hat das EEG ein größeres praktisches Potenzial. Für den Versuch sind die Testpersonen mit EEG-Equipment ausgestattet worden. Dabei wurden ihnen Bilder von Gesichtern gezeigt. Währenddessen ist die Gehirnaktivität der Probanden aufgezeichnet worden, um die Gedankenwelt in digitaler Form nachzubilden. Die hier zum Einsatz kommende Technik basiert auf maschinellen Lernalgorithmen. Dies ist nicht das erste Mal, dass Neuroimaging-Techniken angewendet wurden. Der Unterschied liegt darin, dass hier statt der sonst üblichen fMRI das EEG zum Einsatz kommt.

Mithilfe eines EEGs können wir im Detail sehen, wie sich die Wahrnehmung eines Gesichts im Gehirn bildet

Dan Nemrodov

Im Vergleich zur fMRI birgt das EEG zahlreiche Vorteile. Zum einen ist es kostengünstiger und portabel. Zum anderen bietet es eine genauere zeitliche Auflösung. Das bedeutet, dass der genaue Zeitrahmen ermittelt wird, in dem sich eine Impression entwickelt. Die Genauigkeit liegt dabei im Millisekundenbereich. "Die fMRI ermittelt Aktivität im Sekundenbereich, während das EEG im Millisekundenbereich arbeitet", erklärt Dan Nemrodov von der University of Toronto. "Mithilfe eines EEGs können wir im Detail sehen, wie sich die Wahrnehmung eines Gesichts im Gehirn bildet", fügt Nemrodov hinzu. Die Wissenschaftler konnten feststellen, dass unser Gehirn exakt 170 Millisekunden benötigt, um die Repräsentation eines Gesichts, das wir sehen, anzufertigen. Von einer neurotechnologischen Perspektive aus bieten EEG-Daten laut den Forschern ein großes theoretisches und praktisches Potenzial.

Quelle: University of Toronto/pressetext

13.03.2018