© ipopba – stock.adobe.com

Artikel • Expertendiskussion auf der MEDICA

KI in der Medizin: Vertrauen durch Verstehen

KI soll Diagnosen verbessern, Dokumentationsaufwand reduzieren und Ärzten mehr Zeit für ihre Patienten geben – so das Versprechen. Doch von der Einsatzreife im klinischen Alltag ist die Technologie vielerorts noch ein gutes Stück entfernt. Auf dem MEDICA Innovation Forum diskutierten vier Experten, welche Bedingungen erfüllt sein müssen, damit KI im Gesundheitswesen ihr Versprechen einlösen kann.

Artikel: Wolfgang Behrends

Waclaw Lukowicz, Co-Founder von Key4Lab, identifizierte Bildung als Schlüssel zum erfolgreichen KI-Einsatz: Wenn Mediziner verstehen, wie eine KI funktioniert, schaffe dies Vertrauen und die nötige Sicherheit für deren Anwendung. Dr. Markus Vogel, Chief Medical Information Officer bei Microsoft, betonte die Notwendigkeit einer soliden technischen Infrastruktur: Ähnlich wie bei Mobiltelefonen sollte die Technologie im Hintergrund zuverlässig funktionieren, ohne dass Anwender sich mit technischen Details auseinandersetzen müssen.

Ein Widerspruch? Keineswegs – vielmehr ergänzen beide Voraussetzungen einander: Während eine robuste Infrastruktur die technische Grundlage bildet, ermöglicht Verständnis für die Funktionsweise von KI einen verantwortungsvollen Umgang. Vogel selbst verwies auf eine Analogie: Die meisten Menschen wissen nicht, wie ein Auto technisch funktioniert, nutzen es aber dennoch verantwortungsvoll. Somit müsse nicht jeder Arzt verstehen, wie neuronale Netze trainiert werden, aber ein grundlegendes Verständnis der Möglichkeiten und Grenzen von KI sei unverzichtbar, befanden die Experten.

Realistische Erwartungen setzen

Foto: HiE/Behrends

Damit KI im klinischen Alltag akzeptiert wird, müsse sie nachweislich bessere Ergebnisse liefern als etablierte Methoden, so Vogel – ein Grundprinzip der evidenzbasierten Medizin. Prof. Dr. Paul Lukowicz, Wissenschaftlicher Direktor des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI) und Leiter der Podiumsdiskussion, ordnete diese Erwartung ein: Wie jedes medizinische Verfahren oder Medikament sei auch KI darauf ausgelegt zu helfen, könne aber nie mit absoluter Sicherheit Schäden ausschließen. Es sei unrealistisch, an KI höhere Maßstäbe anzulegen als an andere medizinische Interventionen.

Laut Dr. Harvey Castro, Chief AI Officer bei Phantom Space, gelte für KI das gleiche wie bei jedem anderen Werkzeug: Wenn ein Arzt nicht weiß, wie er es korrekt einsetzt, könne dies Patienten gefährden – ähnlich wie ein Auto, das man nicht zu fahren versteht. Der Output von KI-Systemen wie ChatGPT stelle dabei eine besondere Herausforderung dar: Die generierten Texte wirken oft hochgradig plausibel, sodass Fachkenntnisse erforderlich seien, um valide von fehlerhaften Informationen zu unterscheiden. Waclaw Lukowicz fasste das Risiko prägnant zusammen: Das Potenzial sei enorm, aber bei falscher Anwendung könne KI katastrophale Folgen haben.

Zwischen Kontrolle und Kontext

Menschliche Überwachung ist laut Castro unverzichtbar, um Fehler zu vermeiden. Entwickler müssen zudem die Ausgaben ihrer Modelle kontinuierlich überwachen, um sicherzustellen, dass keine unerwünschten Veränderungen in der Modellleistung – auch als ‚Model Drift‘ bezeichnet – auftreten. Castro warf die Frage auf, wie ‚Deskilling‘ – also ein schleichender Verlust von Qualifizierung – bei Ärzten verhindert werden könne, wenn diese KI-Empfehlungen blind folgen. Seine Antwort: Mediziner müssten ihr kritisches Denken bewahren.

Dieser Artikel könnte Sie auch interessieren

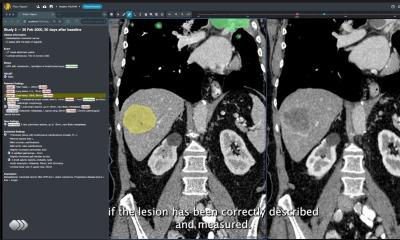

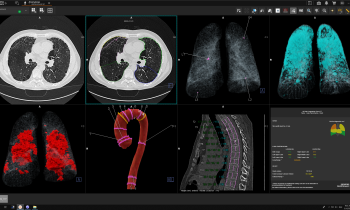

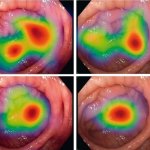

Artikel • Diagnostische Assistenzsysteme

KI in der Endoskopie: Helfer, Trainer – Influencer?

Künstliche Intelligenz (KI) fasst auch in der Endoskopie zunehmend Fuß. Die Algorithmen entdecken Pathologien zwar oft schneller als der Mensch, werfen aber auch neue Probleme auf. PD Dr. Alexander Hann bescheinigt den KI-Helfern großes Potenzial, gibt jedoch zu bedenken, dass ihr Einsatz nicht nur die Befundung verändern kann – sondern auch den Befunder.

Für qualitativ hochwertige KI-Ergebnisse im medizinischen Kontext sind laut Vogel umfassende Wissensdatenbanken und multimodale Eingaben erforderlich. „Es reicht nicht aus, einfach nur einen Prompt in ein Chatfenster zu tippen“, betonte er. Denn ohne den richtigen Kontext könnten selbst ausgereifte KI-Systeme leicht zu falschen Schlussfolgerungen gelangen – mit potenziell schwerwiegenden Folgen für die Patienten. Der Experte nannte natürliche Sprache als wichtige Schnittstelle, um die Interaktion zwischen Mediziner und KI intuitiver zu gestalten und Missverständnisse durch fehlenden Kontext zu vermeiden.

Foto: HiE/Behrends

Zeitgewinn für die Patientenversorgung

Ein wesentlicher Mehrwert von KI liege darin, Ärzten administrative Aufgaben wie die Dokumentation abzunehmen. „Wenn wir Ärzten mehr Zeit geben, ihre Patienten tatsächlich zu behandeln, ist das ein enormer Fortschritt“, sagte Waclaw Lukowicz. Dieser Ansatz verstehe KI nicht als Ersatz für ärztliche Expertise, sondern als Unterstützung, die Freiräume für die eigentliche medizinische Tätigkeit schafft.

Die Diskussion machte deutlich: Der erfolgreiche Einsatz von KI im Gesundheitswesen ist weniger eine technische als vielmehr eine organisatorische und kulturelle Herausforderung. Bildung, kritisches Denken, evidenzbasierte Evaluation und menschliche Aufsicht sind demnach die Eckpfeiler, auf denen ein verantwortungsvoller Einsatz von KI als Begleiter im Gesundheitswesen aufbauen muss. Denn wie Prof. Lukowicz treffend formulierte: Die eigentliche Gefahr liegt nicht in der Technologie selbst, sondern darin, ihr blindes Vertrauen entgegenzubringen.

01.12.2025