Bild: Andreas Heddergott/TUM

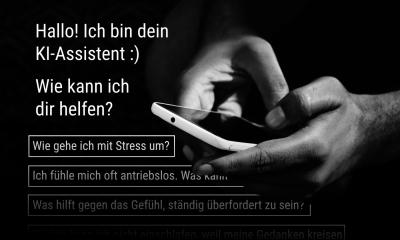

News • "Verkörperte KI"

Ethik: Welche Regeln brauchen Roboter-Therapeuten?

In Zukunft werden wir immer häufiger direkt mit Künstlicher Intelligenz (KI) interagieren. Ein Team der Technischen Universität München (TUM) hat jetzt erstmals systematisch untersucht, wie „verkörperte KI“ schon heute hilft, psychische Erkrankungen zu behandeln. Das Fazit: Wichtige ethische Fragen zu dieser Technologie sind unbeantwortet, es besteht dringender Handlungsbedarf für Regierungen, Fachverbände und Forschung.

Roboter-Puppen, mit denen autistische Kinder lernen, Menschen besser zu verstehen; computergenerierte Avatare, die helfen, mit Halluzinationen umzugehen; virtuelle Chats, die Unterstützung bei Depressionen bieten: Es gibt schon heute zahlreiche Ansätze, die psychische Gesundheit von Menschen mit sogenannter verkörperter Künstlicher Intelligenz zu fördern. Von verkörperter KI spricht man, weil bei diesen Anwendungen Menschen mit einem künstlichen Gegenüber interagieren, wodurch ganz neue Dynamiken entstehen.

Der Einsatz von KI in der Psychotherapie ist an sich nichts Neues. Erste Chatbots erzeugten schon in den 60er Jahren die Illusion eines therapeutischen Gesprächs. Mehr als eine Spielerei war das allerdings nicht. Durch moderne Algorithmen und gestiegene Rechnerkapazitäten ist heute viel mehr möglich. „Die Algorithmen hinter diesen Anwendungen sind mit riesigen Datenmengen trainiert worden und können echte therapeutische Aussagen treffen“, erläutert Alena Buyx, Professorin für Ethik der Medizin und Gesundheitstechnologien an der TUM. Gemeinsam mit Dr. Amelia Fiske und Peter Henningsen, Professor für Psychosomatische Medizin und Psychotherapie, hat sie erstmals einen systematischen Überblick über Anwendungen der verkörperten KI für die psychische Gesundheit erstellt und Chancen und Herausforderungen herausgearbeitet, der nun im Journal of Medical Internet Research veröffentlicht wurde.

Mehr Menschen bekommen Zugang zu Behandlung

Therapeutische KI-Anwendungen sind Medizinprodukte, für die wir entsprechende Zulassungsverfahren und ethische Handlungsvorgaben brauchen

Alena Buyx

Die neuen Anwendungen haben enormes Potential. Sie können mehr Menschen Zugang zu einer Behandlung bieten, weil sie nicht an bestimmte Zeiten und Orte gebunden sind. Einigen Betroffenen fällt es zudem leichter, mit der KI zu interagieren als mit einem menschlichen Gegenüber. Es gibt aber auch Risiken. „Verkörperte KI kann und darf kein billigerer Ersatz für eine Behandlung durch reale Ärztinnen und Ärzte sein“, sagt Amelia Fiske. „Obwohl verkörperte KI schon in der Klinik angekommen ist, gibt es bisher kaum Empfehlungen von medizinischen Fachgesellschaften zum Umgang mit diesem Thema. Das wäre jedoch dringend notwendig, um die Vorteile dieser Technologien zu nutzen und gleichzeitig Nachteile zu vermeiden und ‚Wildwuchs‘ einzudämmen. Außerdem sollte das Thema bereits im Medizinstudium behandelt werden“, sagt Peter Henningsen, der Dekan der TUM-Medizinfakultät ist.

Dieser Artikel könnte Sie auch interessieren

Interview • Recht & Technik

Wer verantwortet falsche KI-Diagnosen?

Die Möglichkeiten von Künstlicher Intelligenz (KI) wachsen rasant an, Algorithmen übernehmen auch in der Radiologie immer mehr Aufgaben – ein Beispiel ist etwa die automatisierte Auswertung radiologischer Bilder. Doch wer trägt die Verantwortung, wenn der Algorithmus einen Fehler macht? Darüber haben wir mit Prof. Dr. Susanne Beck gesprochen. Die Inhaberin des Lehrstuhls für Strafrecht,…

Fehlende Vorgaben für Künstliche Intelligenz

Derzeit werden vermehrt Leitlinien für KI erstellt, etwa die gerade von der EU entwickelten Ethics Guidelines for Trustworthy AI. Zusätzlich dazu sind aus Sicht von Buyx, Fiske und Henningsen allerdings dringend fachspezifische Regeln notwendig. „Therapeutische KI-Anwendungen sind Medizinprodukte, für die wir entsprechende Zulassungsverfahren und ethische Handlungsvorgaben brauchen", sagt Alena Buyx. „Wenn die Programme beispielsweise erkennen können, ob Patienten Suizidgedanken haben, dann müssen sie, genau wie Therapeutinnen und Therapeuten, im Ernstfall klare Warn-Protokolle befolgen."

Darüber hinaus müsse verkörperte KI intensiv auf soziale Effekte hin erforscht werden. „Wir haben kaum Informationen dazu, wie sich der Kontakt mit therapeutischer KI auf uns Menschen auswirkt“, sagt Alena Buyx. „Unter Umständen lernt beispielsweise ein Kind mit einer Störung aus dem Autismus-Spektrum durch den Kontakt mit einem Roboter nur, wie man besser mit Robotern umgeht – aber nicht mit Menschen.“

Quelle: Technische Universität München

15.05.2019