Bildquelle: Andreas Schmitz / TUM

News • Muskelaktivität verstehen

KI-Prothese macht das Greifen intuitiver

Aktuelle Handprothesen funktionieren bereits mit Hilfe einer App oder mit Sensoren, die am Unterarm angebracht sind. Neue Forschungen an der Technischen Universität München (TUM) zeigen: Ein besseres Verständnis der Muskelaktivitätsmuster ermöglicht eine intuitivere und natürlichere Steuerung der Prothesen.

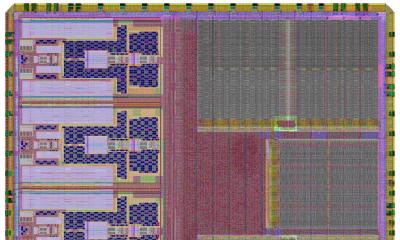

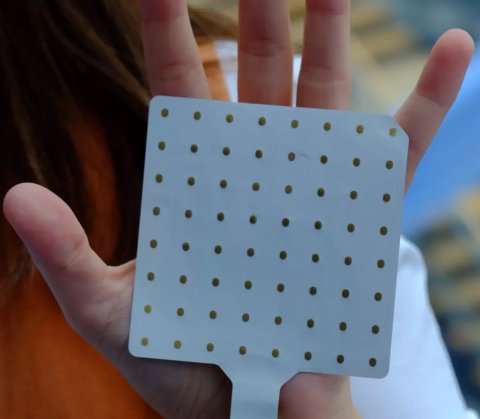

Dafür sind ein Netzwerk aus 128 Sensoren sowie der Einsatz von Künstlicher Intelligenz nötig.

Auf der IEEE International Conference on Rehabilitation Robotics stellte das Team seine Erkenntnisse vor.

Unterschiedliche Arten von Greifern und bionisches Design: Technologische Entwicklungen haben Handprothesen in den letzten Jahrzehnten immer weiter verbessert. Wer durch einen Unfall oder eine Erkrankung eine Hand verloren hat, kann so immerhin einige der alltäglichen Bewegungen wieder ausführen. Mit einigen modernen Prothesen lassen sich bereits die Finger bewegen oder das Handgelenk drehen. Erforderlich sind entweder eine Smartphone-App oder aber Muskelsignale aus dem Unterarm, die üblicherweise von zwei Sensoren detektiert werden. Zum Beispiel lassen sich durch Aktivierung des Beugemuskels (Flexor) im Handgelenk die Finger der künstlichen Hand schließen, und so ein Stift greifen. Ist der Streckmuskel (Extensor) im Handgelenk kontrahiert, lässt die Hand den Stift wieder los. Sind beide Muskeln gleichzeitig angespannt, lassen sich bestimmte Finger bewegen. “Diese Bewegungen muss ein Patient während der Rehabilitation lernen”, sagt Cristina Piazza, Professorin für Healthcare und Rehabilitation Robotics an der TUM. Jetzt hat ihr Forschungsteam gezeigt, dass künstliche Intelligenz dazu beitragen kann, eine Handprothese intuitiver zu nutzen als bisher. Das Geheimnis liegt im “Synergieprinzip” sowie der Unterstützung von 128 Sensoren am Unterarm.

Bildquelle: Andreas Schmitz / TUM

Was versteht man unter dem Synergieprinzip? “Wir wissen aus neurowissenschaftlichen Studien, dass gewisse Muster in Experimenten immer wieder auftauchen, sowohl in der Kinematik als auch hinsichtlich der Muskelaktivierung,” sagt Prof. Piazza. Diese Muster geben Hinweise darauf, wie das menschliche Gehirn mit der Komplexität von biologischen Systemen umgeht. Das Gehirn aktiviert eine Gruppe von Zellen gleichzeitig. Auch im Unterarm ist das so. Piazza: “Wenn wir mit unserer Hand ein Objekt greifen wollen, etwa einen Ball, bewegen wir unsere Finger synchron und sie passen sich sofort an die Form des Objektes an, sobald es berührt wird.” Die Forschenden nutzen das Prinzip nun für das Design und die Steuerung von künstlichen Händen, indem sie neue Lernalgorithmen einsetzen. Für Menschen ist die intuitive Bewegung ganz normal: Aus Roboterperspektive sieht das anders aus. Wenn eine künstliche Hand einen Stift greift, führt sie viele einzelne Schritte nacheinander aus. Erst bestimmt sie den Ort, von dem sie etwas greifen will. Dann führt sie langsam die Finger zusammen, bevor sie schließlich den Stift greift. Das Ziel der Forschenden besteht darin, eine einzige fließende Bewegung daraus zu machen. “Mit Hilfe von Maschinellem Lernen können wir die Steuerung anpassungsfähiger machen”, sagt Patricia Capsi Morales, Senior Scientist in Prof. Piazzas Team.

Bildquelle: Andreas Schmitz / TUM

Experimente mit dem neuen Ansatz deuten bereits darauf hin, dass herkömmliche Steuerungsmethoden bald durch fortschrittlichere Strategien unterstützt werden könnten. Um zu untersuchen, was auf der Ebene des zentralen Nervensystems geschieht, arbeiten die Forscher mit zwei Sensorfolien: eine für die Innen- und eine für die Außenseite des Unterarms. Jede Folie enthält bis zu 64 Sensoren. Die Methode schätzt auch ab, welche elektrischen Signale die Motoneuronen im Rückenmark übertragen haben. “Je mehr Sensoren wir verwenden, desto besser können wir Informationen von verschiedenen Muskelgruppen erfassen und herausfinden, welche Muskelaktivierungen für welche Handbewegungen verantwortlich sind”, erläutert Prof. Piazza. Je nachdem, ob ein Mensch eine Faust macht, einen Stift greift oder ein Marmeladenglas öffnen will, ergeben sich laut Forscherin Capsi Morales "charakteristische Merkmale der Muskelsignale" – eine Voraussetzung für intuitive Bewegungen.

Wir nutzen Signalverarbeitungstechniken, um das Rauschen herauszufiltern und verwertbare Signale zu erhalten

Patricia Capsi-Morales

Die aktuelle Forschung konzentriert sich auf die Bewegung des Handgelenks und der gesamten Hand. Sie zeigt, dass die meisten Menschen (acht von zehn) die intuitive Bewegung von Handgelenk und Hand bevorzugen. Das ist zudem der effizientere Weg. Dennoch: Zwei von zehn Personen lernen, mit der weniger intuitiven Methode umzugehen und werden am Ende sogar präziser. “Unser Ziel ist es, den Lerneffekt zu untersuchen und die richtige Lösung für jeden Patienten zu finden”, erläutert Capsi Morales. “Dies ist ein Schritt in die richtige Richtung”, sagt Prof. Piazza, die betont, dass jedes System aus individueller Mechanik und Eigenschaften der Hand, speziellem Training mit Patienten, der Interpretation und Analyse sowie maschinellem Lernen besteht.

Es stehen noch einige Herausforderungen bevor: Der Lernalgorithmus, der auf den Informationen der Sensoren basiert, muss jedes Mal neu trainiert werden, wenn die Folie verrutscht oder entfernt wird. Außerdem müssen die Sensoren mit einem Gel präpariert werden, um die notwendige Leitfähigkeit zu gewährleisten. Nur so können die Signale der Muskeln präzise aufgezeichnet werden. “Wir nutzen Signalverarbeitungstechniken, um das Rauschen herauszufiltern und verwertbare Signale zu erhalten”, so Capsi Morales weiter. Jedes Mal, wenn ein neuer Patient die Manschette mit den vielen Sensoren am Unterarm trägt, muss der Algorithmus zunächst die Aktivierungsmuster für jede Bewegungssequenz identifizieren, um später die Absicht des Benutzers zu erkennen und sie in Befehle für die künstliche Hand zu übersetzen.

Quelle: Technische Universität München

05.12.2023