Bildquelle: ThankYouFantasyPictures auf Pixabay (Bild generiert mithilfe des KI-Tools Stable Diffusion)

News • Meilenstein für KI

ChatGPT: Neue Version besteht Radiologen-Prüfung

Die neueste Version von ChatGPT hat eine Prüfung der Radiological Society of North America (RSNA) bestanden. Das unterstreicht das Potenzial großer Sprachmodelle, zeigt aber auch Grenzen auf, so Experten.

In "Radiology", einem Fachjournal der RSNA, diskutieren Experten die Leistung der KI beim Testverfahren.

"Die Verwendung großer Sprachmodule wie ChatGPT explodiert und wird noch zunehmen", so Prüfer Rajesh Bhayana, Radiologe am Toronto General Hospital. "Unsere Forschung gibt Aufschluss über die Leistung von ChatGPT im radiologischen Kontext und unterstreicht das unglaubliche Potenzial großer Sprachmodule sowie die derzeitigen Einschränkungen, die es unzuverlässig machen." Das könne Gefahren mit sich bringen, denn ChatGPT und ähnliche Chatbots würden in Suchmaschinen wie Google und Bing integriert, die Ärzte und Patienten verwenden, um nach medizinischen Infos zu suchen, so Bhayana.

Dieser Artikel könnte Sie auch interessieren

News • Themenkanal

Blickpunkt: KI in der Medizin

Künstliche Intelligenz soll menschliche Denkprozesse nachbilden und die Arbeit fast aller medizinischer Teilgebiete erleichtern. Doch was geht im Inneren eines KI-Algorithmus vor, worauf basieren seine Entscheidungen? Kann man einer Maschine gar eine medizinische Diagnose anvertrauen?

Das Team hat die ChatGPT-Version GPT-3.5 getestet, die derzeit am häufigsten verwendet wird. Die Prüfung bestand aus 150 Multiple-Choice-Fragen, die auf den Stil, den Inhalt und den Schwierigkeitsgrad der Prüfungen des Canadian Royal College und des American Board of Radiology abgestimmt waren. Dabei ging es um das Abrufen von Wissen und das Grundverständnis, um Anwendungen, Analysen und Synthesen sowie Beschreibungen der Bildgebungsbefunde, klinisches Management, Berechnung und Klassifikationen.

Wir waren überrascht von den großenteils genauen und selbstbewussten Antworten von ChatGPT auf einige herausfordernde radiologische Fragen, aber dann ebenso überrascht von einigen sehr unlogischen und ungenauen Behauptungen

Rajesh Bhayana

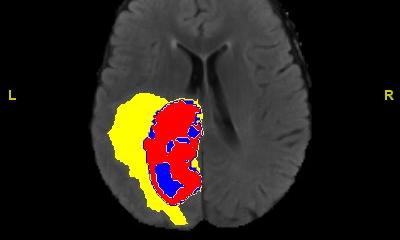

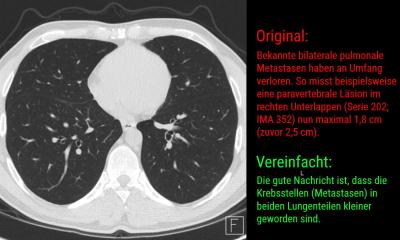

GPT-3.5 beantwortete 69% der Fragen richtig (104 von 150). Für ein Bestehen der Prüfung wären nach der Praxis des Royal College in Kanada 70% nötig gewesen. Das Modell schnitt bei Wissensfragen mit 84% richtigen Antworten (51 von 61) am besten ab, hatte aber Probleme mit Fragen, die das Denken höherer Ordnung betrafen (60%, 53 von 89). Genauer gesagt, hatte die Software Probleme bei der Beschreibung der Bildgebungsbefunde (61% richtig, 28 von 46), der Berechnung und Klassifizierung (25%, zwei von acht) und der Anwendung von Konzepten (30%, drei von zehn). Die schlechte Leistung bei Denkfragen höherer Ordnung ist wegen fehlender radiologiespezifischer Vorschulung nicht überraschend, so Bhayana.

Die Nachfolge-Software GPT-4, die im März 2023 in begrenzter Form für zahlende Nutzer freigegeben wurde, machte es besser: Sie bestand die Prüfung mit 81% richtigen Antworten. Insbesondere registrierten die Radiologen Verbesserungen bei anspruchsvolleren Aufgaben. "Wir waren überrascht von den großenteils genauen und selbstbewussten Antworten von ChatGPT auf einige herausfordernde radiologische Fragen, aber dann ebenso überrascht von einigen sehr unlogischen und ungenauen Behauptungen. Es ist gefährlich, sich nur auf ChatGPT zu verlassen", so Bhayanas Fazit.

Quelle: Radiological Society of North America/pressetext

19.05.2023