Interview • Bilddatenverarbeitung

Innovationen jenseits der Hardware

Die Entwicklung der Hardware schreitet rasant voran, jedes Jahr werden neue technologische Innovationen hervorgebracht. Doch auch ein Blick jenseits der Hardware wird zunehmend wichtiger, denn Verbesserungen auf der einen Seite produzieren nutzbarere Ergebnisse auf der anderen Seite, die zudem adäquat strukturiert, analysiert und gespeichert werden müssen.

Einen solchen Blick auf die sich daraus ergebenden Möglichkeiten wirft Prof. Dr. Bjoern Menze, Assistenzprofessor am Lehrstuhl für Informatikanwendungen in der Medizin & Augmented Reality an der TU München in unserem Interview.

Was ist mit den heute schon zahlreich vorhandenen Bilddaten möglich und was kann im Umgang mit diesen Daten verbessert werden?

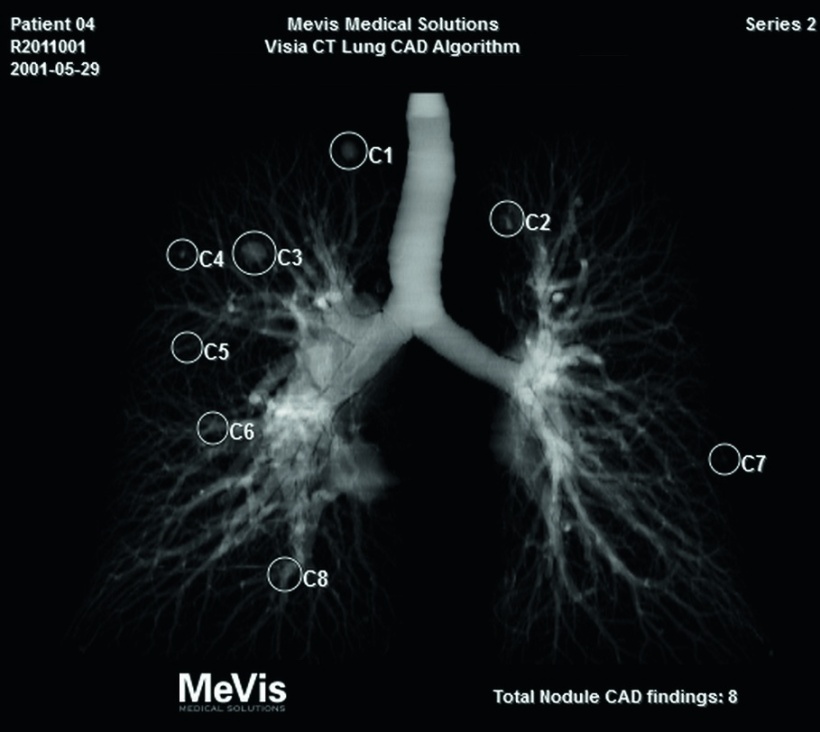

Ein wichtiges Thema, sowohl jetzt als auch in Zukunft, ist die Automatisierung der Bildauswertung. Nach heutigem Stand können Ärzte anatomische Strukturen, wie zum Beispiel bestimmte Areale in Organen im MRT oder einzelne Knochen im CT, gut auffinden. Sie können Gefäße analysieren oder mikrostrukturelle Eigenschaften oder den Blutfluss interpretieren, wenn ihnen die jeweiligen Bilder vorliegen. All das kostet jedoch in der klinischen Routine Zeit, sodass in der Regel nur stichprobenartig untersucht beziehungsweise dokumentiert wird, zumeist sogar nur anhand von qualitativen Messzahlen. Das durch Algorithmen der Mustererkennung und des maschinellen Lernens zu ersetzen oder zumindest zu ergänzen, ist eine der großen Aufgaben der medizinischen Bildverarbeitung.

Eine weitere Richtung ist die Analyse komplexer Muster, etwa bei gleichzeitiger Bewertung verschiedener Bildmodalitäten in der Tumordiagnostik, bei der Bewertung von Zeitserien und longitudinalen Studien oder beim Vergleich bestimmter pathologischer Strukturen mit ähnlichen Bildern in Datensätzen mit Tausenden oder mehr Referenzbildern.

Die Software ist mittlerweile imstande, Artefakte mit guten Ergebnissen aus Bildern herauszurechnen und immer größere Auflösungen zu produzieren. Welche Möglichkeiten bietet das in der Zukunft?

Die Bildverarbeitung und die darauf basierende Informationsverarbeitung sind immer nur so gut wie die Bilder, die dem Ganzen zugrunde liegen. Aktuell sind Datensätze oft sehr inhomogen, was ein bekanntes Standardproblem in Big Data darstellt. Bessere Bilder, das heißt artefaktfreie Bilder, bedeuten, dass automatische Algorithmen immer zuverlässiger anwendbar sein werden. So werden die Bilder verschiedener Scanner und verschiedener Krankenhäuser homogener und damit auch besser vergleichbar.

Große Datenmengen bedeuten, dass die Informationen immer stärker gefiltert werden müssen, bevor sie bewertet oder auch nur archiviert werden. Deshalb werden in Zukunft Algorithmen bei der Auswertung im Hintergrund laufen, um die Auswertung für die jeweilige Fragestellung zu vereinfachen, aber auch, um die aufgenommenen Bilder auf vordefinierte Listen von Incidental Findings abzuprüfen.

An welcher Stelle beginnen die Limitationen?

Technologisch gesehen gibt es relativ wenige Probleme, die sich nicht lösen ließen. Im Wesentlichen sind nur Ressourcen für das Engineering notwendig, vor allem für die Entwicklung von Produkten, die klinisch implementiert werden können. Notwendig werden zudem Investitionen in Infrastrukturen, die den Einsatz großer homogener Datensätze in einheitlichen Datenbanken erlauben. Hier ist die Gesetzgebung gefragt, denn die kritische Frage der Datensicherheit wird an diesem Punkt relevant. Ebenso muss man sich vor dem Hintergrund der noch zu inhomogenen Datensätze mit Standardisierungen befassen. Ob man diese Limitationen zur Gänze wird beheben können, hängt auch davon ab, mit welchen Ergebnissen die öffentliche Diskussion über die elektronische Speicherung personalisierter Informationen geführt wird.

In welche Richtung, glauben Sie, führt die Entwicklung und wo ist der Schwerpunkt zu legen?

Ich glaube, dass wir bei den Interventionen erst am Anfang der Möglichkeiten stehen. Die Visualisierung ist ein extrem wichtiges Thema und anhand von jetzt schon verfügbaren Datenbrillen lässt sich vorausahnen, in welche Richtung die Entwicklung noch gehen könnte. Sehr spannend wird dabei das Thema „Human-Computer Interaction (HCI)“ und die damit einhergehenden Möglichkeiten. Auch die Personalisierung der Therapie, etwa bei Tumorpatienten, wird weiterhin ein wichtiges Gebiet sein.

Die Vision ist, dass Algorithmen künftig Bildvolumen automatisiert auswerten und die gesamte Bildinformation in eine Anzahl Messwerte überführen.

Prof. Dr. Bjoern Menze

Von der technologischen Seite sollte der Schwerpunkt momentan auf der Strukturierung von Bildinformationen für große Datensätze liegen. Diese adäquat zu vereinheitlichen und nutzbar zu machen, ist die größte Herausforderung, vor der wir stehen. Die Vision ist, dass Algorithmen künftig Bildvolumen automatisiert auswerten und die gesamte Bildinformation in eine Anzahl Messwerte überführen – ähnlich wie in einem Bericht zu Blutwerten, die im Labor bestimmt wurden. Diese Messwerte werden dann quantitativ beschreiben, was in dem Bild zu sehen ist, wo sich das Bild signifikant zum Beispiel von einer Voruntersuchung unterscheidet, und wo anatomische Strukturen von der Populations-Norm abweichen.

Vielen Dank für das Interview!

Profil:

Prof. Dr. Bjoern Menze ist Assistenzprofessor am Lehrstuhl für Informatikanwendungen in der Medizin & Augmented Reality an der Technischen Universität München. Seit 2014 sitzt er der Image-Based-Biomedical-Modeling-(IBBM-)Gruppe am TUM Institute of Medical Engineering (IMETUM) der TU München vor. Menze ist spezialisiert in den Bereichen Medical Computer Vision, Image-based Modeling und Computational Physiology und ist auf Anwendungen im klinischen Neuroimaging und in der Modellierung von Tumorwachstum fokussiert.

18.01.2016