Hirnaktivität

Wachkoma: System soll Patienten helfen, sich zu verständigen

Ein neues Gerät soll schwersthirngeschädigten Menschen helfen, mit anderen Personen zu kommunizieren. Der „NeuroCommTrainer“ soll Gehirnsignale verstehen und den Patienten durch EEG-Messung zum Beispiel ermöglichen, mit „Ja“ und „Nein“ zu antworten. Der Clou: Das System trainiert mit den Patienten, ihre Gehirnaktivitäten gezielt zu steuern.

Die Gehirnforscherin Professorin Dr. Johanna Kißler vom Exzellenzcluster Kognitive Interaktionstechnologie (CITEC) der Universität Bielefeld leitet die neue Forschung. Für das Projekt arbeiten drei Hochschulen, zwei Unternehmen und die v. Bodelschwinghschen Stiftungen Bethel zusammen.

Ins Wachkoma fallen Menschen, wenn sie beispielsweise bei einem Unfall oder einer starken Gehirnblutung schwere Hirnschädigungen erlitten haben. Oft nehmen die Ärzte an, dass sie vegetativ, also ohne Bewusstsein sind. „Doch in mehr als einem Drittel der Fälle erweist sich das als Fehldiagnose“, sagt Johanna Kißler. Die Psychologin will dafür sorgen, dass diese Patienten sich mit einfachen Antworten verständlich machen können. Dafür setzt sie auf EEG (Elektroencephalographie). Mit dieser Technologie lassen sich Hirnaktivitäten mittels Elektroden auf der Kopfhaut messen. „Es gibt zwar heute schon Gehirn-Computer-Schnittstellen, durch die Menschen über Hirnsignale kommunizieren können. Sie eignen sich aber nicht für bewusstseinsgestörte Patienten“, sagt Kißler. „Unser System hat den Vorteil, dass es sich an die Person anpasst. Denn es erkennt Phasen optimaler Wachheit, in denen sie am besten ansprechbar sind.“ Außerdem trainiert es den Patienten dabei, seine Aufmerksamkeit und damit seine Hirnsignale zu lenken. „Und es trainiert das Sprachverständnis. Das ist nötig, weil Hirnschädigungen oft dazu führen, dass Menschen einen Teil ihres Wortschatzes einbüßen“, sagt Kißler.

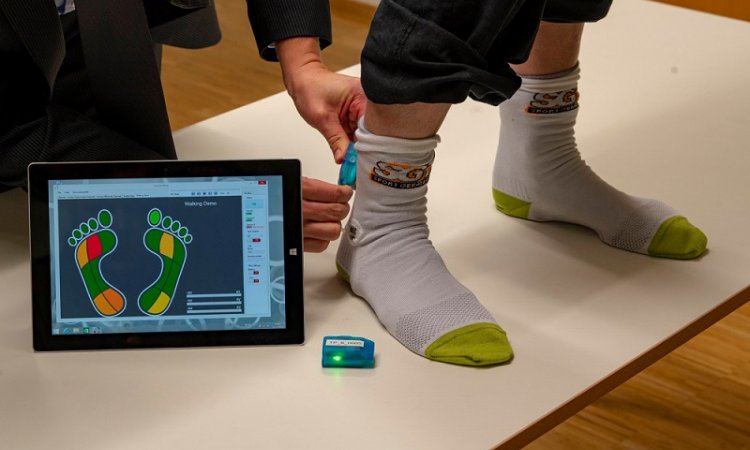

Grundlage des NeuroCommTrainers ist ein Programm, das Muster in der Hirnaktivität erkennt. „Damit wir erfahren, was der Patient sagen will, muss das System die Strukturen in den Gehirnsignalen sozusagen lesen, verstehen und übersetzen“, sagt Johanna Kißler. Für das neue System entwickelt das Forschungsprojekt mehrere Komponenten – darunter winzige EEG-Sensoren. Sie senden die Hirnsignale an einen Computer, der sie auswertet. Um Reaktionen der Patienten zu erfassen, wird das System auch mit Temperatur-, Kontakt-, Kraft-, und Dehnungssensoren ausgestattet. Mit ihnen werden schwache motorische Reaktionen der Finger und Hände erkannt. Gleichzeitig werden über solche Sensoren auch Signale ausgesendet, um die Patienten anzuregen. Weil alle Sensoren klein und dezent sind und ihren Träger nicht stören, eignet sich das System auch für die Langzeitmessung und -stimulation.

Kißlers Forschungsgruppe Allgemeine Psychologie testet den NeuroCommTrainer in der Pflegeeinrichtung Haus Elim der v. Bodelschwinghschen Stiftungen Bethel in Bielefeld. „Um Kontakt zu den Wachkoma-Patienten aufzubauen, arbeiten wir mit akustischen Reizen, etwa Lieblingsmusik“, sagt Kißlers Mitarbeiterin Dr. Inga Steppacher, die die neue Technik im Haus Elim erprobt. Steppacher wird mit den Patienten einüben, über Gedankensteuerung Fragen zu beantworten. „Dafür trainieren wir im ersten Schritt das Sprachverständnis“, sagt Kißler. Die Forscher machen sich eine Besonderheit des Gehirns zunutze: Nimmt ein Patient einen unsinnigen Satz wahr („Das Brot ist zu heiß zu Hund“), misst das EEG im Gehirn einen typischen Ausschlag, der 400 Millisekunden verzögert auftritt (N400-Antwort). „Durch dieses Training erfahren wir, ob der Patient die Bedeutung eines Satzes versteht. Erst wenn das klappt, üben wir mit dem Patienten, auf Fragen per Gehirn mit Ja und Nein zu antworten.“ Dafür nutzt das Team eine weitere bestimmte Hirnreaktion, die P300-Antwort. Sie tritt auf, wenn der Patient einen Tonreiz – wie die Stimme des Partners – wahrnimmt. „Dadurch können wir mit den Patienten üben, die P300-Antwort zu geben, um auf eine Frage mit Ja zu antworten.“

An der automatischen Analyse der EEG-Signale des NeuroCommTrainers arbeitet die Forschungsgruppe Neuroinformatik von Professor Dr. Helge Ritter, Koordinator des Exzellenzclusters CITEC. Sein Team entwickelt ein Programm, das den vermeintlichen Wirrwarr an Daten in Echtzeit filtert und auswertet. „Dieser Klassifikator leitet aus den gemessenen Gehirnsignalen zum Beispiel ab, wann ein Patient auf einen Reiz wie etwa ein emotionales Geräusch reagiert und wann sein Gehirn nicht antwortet“, sagt Helge Ritter. „Das Besondere ist, dass der Klassifikator die eigene Sprache des individuellen Gehirns lernt und so die Hirnsignale der Person versteht.“

Die CITEC-Forschungsgruppe „Ambient Intelligence“ (Umgebungsintelligenz) von Dr. Thomas Hermann arbeitet wiederum daran, die EEG-Daten zu verklanglichen. „Wenn ein Pfleger oder eine Pflegerin zum Beispiel eine Stunde abwesend war, kann diese Person nachhören, ob es in dieser Zeit auffällige Hirnsignale gab“, erklärt Thomas Hermann. Hermanns Team arbeitet für das Projekt auch an den tragbaren Sensoren und an Impulsgebern (Haptuatoren), die akustische Vibrationen aussenden. „Anders als lange Zeit angenommen, nehmen Komapatienten tatsächlich Berührungsreize wahr“, sagt Kißler. Die Haptuatoren sollen zum Beispiel unauffällig in die Kleidung eingewebt werden. Sie sollen der Person dazu verhelfen, die Prozesse in ihrem Gehirn wahrzunehmen: Eine Patientin wird etwas gefragt („Schmerzt dein Rücken?“), sie lenkt ihre Aufmerksamkeit und aktiviert so eine bestimmte Hirnregion. Der NeuroCommTrainer versteht die Antwort („Ja.“) und bestätigt das durch zwei kurze Vibrationen. Biofeedback nennt sich dieses Prinzip.

Quelle: Universität Bielefeld

26.05.2017