Zurück in die Zukunft

Eine Reise durch die Geschichte der Computertomographie von damals bis heute

Mit atemberaubendem Tempo haben sich die Fortschritte der Computertomographie in den letzten vier Jahrzehnten vollzogen. Welche technischen Meilensteine waren es, die das Verfahren immer weiter vorangetrieben haben? Und was ist in naher Zukunft zu erwarten?

Aus Anlass des 7. Mehrschicht CT Symposiums lässt einer der hellsten Physiker-Köpfe der CT-Forschung und -Entwicklung, Prof. Dr. Thomas Flohr von Siemens Healthcare, die wichtigsten Stationen des CT-Werdegangs noch einmal Revue passieren.

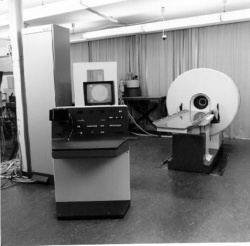

Zum ersten Mal tauchte die Computertomographie in den 1970ern auf. „Sie war die erste Bildgebungsmethode, mit der sich Schnittbilder vom Patienten darstellen ließen“, so Prof. Flohr. „Damit löste diese neue Technik das Problem des konventionellen Röntgens, bei dem sich die Strukturen im Bild überlagern.“ Im darauffolgenden Jahrzehnt entwickelte sich die CT dann von Kopfscannern zu Ganzkörpersystemen, die mit immer schnelleren Rotationszeiten der Gantry immer schneller Bilder aufnehmen konnten.

Ende der 1980er wurde die CT dann das erste Mal für tot erklärt. Man glaubte, die Zukunft gehöre allein der neu aufkommenden MRT-Technologie. Aber Totgeglaubte leben bekanntlich länger und die CT erfand sich neu: „Mit der Einführung der Spiral-Technik gelang ein wesentlicher Evolutionssprung. Bis zu diesem Zeitpunkt rotierte das System einmal um den Patienten und erfasste dabei eine Schicht. Dann musste der Patiententisch zur nächsten Stelle bewegt werden und die nächste Schichtaufnahme erfolgte. So generierte man beispielsweise für die Leber 20 Einzelaufnahmen. Dieses Prozedere beanspruchte natürlich viel Zeit. Bei der Spiral-CT rotiert das Mess-System dagegen kontinuierlich um den Patienten während der Tisch in die Gantry gefahren wird und nimmt gleichzeitig die ganze Zeit Daten auf.“

Das verkürzt nicht nur Untersuchungszeit, sondern mindert auch die Gefahr, Areale überhaupt nicht oder doppelt zu messen. Von dieser Innovation lebt die CT bis heute. 1998 gelang ein weiterer Durchbruch: Die ersten Mehrschicht-CTs wurden vorgestellt. „Diese erste Generation konnte vier Schichten gleichzeitig aufnehmen“, erläutert Flohr. „Dadurch ließen sich Untersuchungen viel schneller durchführen oder viel größere Scanbereiche wie der Thorax oder das Abdomen in einer Atemanhaltephase erfassen. Zudem wurde eine bessere räumliche Auflösung mit immer dünnerer Schichtdicke erreicht.“

Frei nach dem Motto „Höher, schneller, weiter“ standen die Jahre ab 2000 im Zeichen der Weiterentwicklung der Mehrschicht-CT: von 4, 6, 8, 16, auf 64 und 128 Zeilen. „Während die bisherigen Entwicklungsschritte noch eine erhebliche Erweiterung der klinischen Möglichkeiten bedeuteten, ist eine weitere Erhöhung der Zeilenzahl langsam nicht mehr wirklich sinnvoll“, meint der Physiker. „Ein 64-Zeiler kann alle Routineuntersuchungen mit Submillimeterauflösung in wenigen Sekunden durchführen.“ Auch die räumliche Auflösung von Computertomographen stößt inzwischen an ihre Grenzen. „Im Moment liegt die Auflösungsgrenze bei etwa 0,3 mm. Eine noch höhere Auflösung wäre zwar im Prinzip für manche Anwendungen wünschenswert, müsste aber mit mehr Strahlung erkauft werden.“

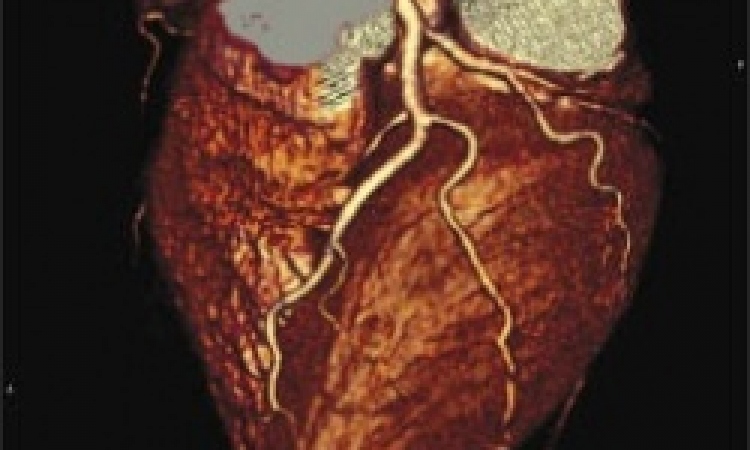

Durch bessere zeitliche Auflösung aufgrund immer schnellerer Gantryrotation wurden in den letzten zehn Jahren auch neue Anwendungsgebiete für die CT erschlossen, wie die Untersuchung des Herzens und der Herzkranzgefäße. In vielen Fällen kann die Herz-CT heute den invasiven Herzkatheter ersetzen. Ein wesentlicher Entwicklungsschritt war hier die Einführung der Dual-Source-Technologie im Jahre 2005. „Damit konnte die zeitliche Auflösung um den Faktor zwei auf Werte deutlich unter 100 ms verbessert werden. Das reicht aus, um auch Patienten mit hohen und unregelmäßigen Herzraten zuverlässig untersuchen zu können“ sagt Flohr.

Geht es um die Zukunft der CT, so sieht Prof. Flohr drei mögliche Entwicklungen. Der erste Schritt geht in Richtung Automatisierung: „Da die CT heute als Working Horse im klinischen Setting eingesetzt wird, muss der Workflow weiter vereinfacht und beschleunigt werden. Schon heute bieten viele Maschinen dem Benutzer vereinfachte Bedienabläufe und Hilfestellungen bei komplexen Prozeduren. Dieser Trend wird sich weiter verstärken.“

Eine zweite Entwicklungsrichtung betrifft die Ergänzung der anatomischen Bildinformationen um funktionelle Aussagekraft. Mit kombinierten Geräten wie dem PET-CT, aber auch mit neuen Untersuchungstechniken wie der CT-Perfusionsbildgebung oder der Dual-Energy-CT lässt sich z. B. bei modernen Krebstherapien durch die Visualisierung metabolischer Prozesse eine Prognose für das Therapieansprechen zeitnah abgeben.

Die dritte große Stoßrichtung bezeichnet Prof. Flohr auch als „Pferdefuß der CT“: Die Strahlendosis. Die Dosisbelastung ist zu einem großen öffentlichen Thema auch außerhalb der Medizin geworden, auf das alle Großgerätehersteller reagiert haben.

Die Meinungen über die Auswirkungen von stochastischen Strahlenschäden klaffen jedoch weit auseinander: „Unsere Datenquellen beruhen noch heute auf den Untersuchungen der Hiroshima- und Nagasaki-Strahlenopfer. Eine sehr konservative Abschätzung geht davon aus, dass eine CT-Untersuchung mit typischerweise 10 mSV das Krebsrisiko um etwa 0,05 % erhöht. Das allgemeine Krebsrisiko liegt dagegen bei etwa 30 %.

Die Gefahr, langfristig gesundheitliche Schäden durch eine CT-Untersuchung davonzutragen, ist also sehr gering. Wenn eine CT-Untersuchung medizinisch indiziert ist, übertrifft ihr Nutzen das mögliche Risiko bei weitem. Dennoch müssen wir weiter versuchen, die Dosis so weit wie möglich zu reduzieren.“

Aktuelle Strategien zur Dosisreduktion verfolgen ganz unterschiedliche Ansätze: durch an die Anatomie des Patienten adaptierte Röhrenstromstärke, an die Untersuchung und die Statur des Patienten adaptierte Röhrenspannung oder – ganz neu – durch iterative Rekonstruktionsverfahren. „Die Iterative Rekonstruktion war für die CT bis vor wenigen Jahren aus Gründen der Rechenleistung nicht verfügbar“, berichtet Flohr. „Das Verfahren beruht auf Rückkoppelungs- und Vergleichsprozessen, die erstens Artefakte im Bild korrigieren und zweitens das Rauschen verringern, ohne die Schärfe zu beeinflussen. Dieser Effekt ist es, der zur Dosisreduktion führt.“

Zurzeit tüfteln Prof. Flohr und seine Kollegen bei Siemens daran, wie man mit der Iterativen Rekonstruktion nicht nur das Rauschen, sondern auch die räumliche und zeitliche Auflösung im Bild verbessern kann. Stillstand in der Entwicklungsgeschichte der Computertomographie ist also noch lange nicht in Sicht.

Im Profil

Apl. Prof. Dr. rer. nat. Thomas Flohr, geboren 1960 in Neustadt/Aisch, ist seit 21 Jahren bei Siemens Healthcare mit der Forschung und Entwicklung im Geschäftsgebiet Computertomographie befasst.

Der Physiker ist seit 1996 für die Konzeptentwicklung der Multischicht-CT-Technologie verantwortlich und leitet seit dem Jahr 2003 auch die CT-Physik und Applikationsvorentwicklung.

1998 ehrte das Unternehmen ihn mit der Auszeichnung „Erfinder des Jahres“. Nebenher habilitierte sich Thomas Flohr an der Universität Tübingen und lehrt dort als Außerplanmäßiger Professor für Medizinische Physik.

10.01.2012