Bild: Astrid Eckert / TUM

News • Deep Learning blickt unter die Haut

Selbstlernende Algorithmen analysieren medizinische Bilddaten

Bildgebende Verfahren ermöglichen einen detaillieren Blick ins Innere eines Organismus. Doch die Interpretation der Daten ist zeitaufwändig und erfordert viel Erfahrung. Neue Möglichkeiten eröffnen künstliche neuronale Netzwerke.

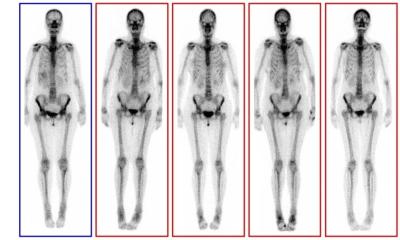

Sie benötigen nur Sekunden, um Ganzkörperscans von Mäusen auszuwerten und die Organe, statt in verschiedenen Schattierungen von Grau, zu segmentieren und in Farbe darzustellen. Dies erleichtert die Auswertung erheblich.

Zusammen mit einem interdisziplinären Forschungsteam hat Oliver Schoppe jetzt selbstlernenden Algorithmen entwickelt, die künftig bei der Analyse biowissenschaftlicher Bilddaten helfen können. Die Wissenschaftler veröffentlichten ihre Erkenntnisse jetzt im Journal Nature Communications.

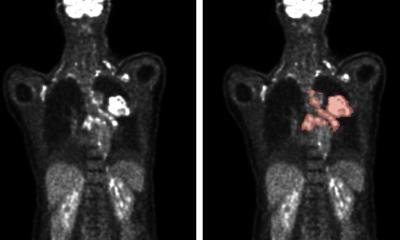

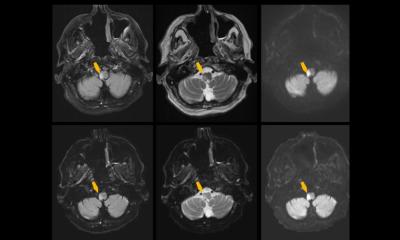

Wie groß ist die Leber? Verändert sie sich durch die Einnahme von Medikamenten? Ist die Niere entzündet? Befindet sich im Gehirn ein Tumor? Und hat dieser bereits Metastasen gebildet? Um solche Fragen beantworten zu können, mussten Biowissenschaftler und Mediziner bisher eine Fülle von Daten sichten und interpretieren. „Die Auswertung von dreidimensionalen bildgebenden Verfahren ist sehr aufwändig“, erklärt Schoppe, Forscher an der Technischen Universität München (TUM).

Kernstück der AIMOS-Software – die Abkürzung steht für AI-based Mouse Organ Segmentation – sind künstliche neuronale Netze, die, wie das menschliche Gehirn, lernfähig sind. „Früher musste man Computerprogrammen genau sagen, was sie tun sollen“, erläutert Schoppe. „Neuronale Netze brauchen solche Vorgaben nicht mehr: Es genügt sie zu trainieren, indem man mehrmals eine Problemstellung und eine Lösung präsentiert. Die Algorithmen erkennen nach und nach die Muster und finden dann selbst die richtigen Lösungen.“

Wir haben nur etwa zehn Ganzkörperscans gebraucht, dann konnte die Software die Analyse der Bilddaten allein bewerkstelligen – und zwar innerhalb von Sekunden. Ein Mensch braucht dafür Stunden.

Oliver Schoppe

Im AIMOS-Projekt wurden die Algorithmen mit Hilfe von Mäusebildern trainiert. Ziel war es, die Bildpunkte aus 3D-Ganzkörperscans bestimmten Organen – beispielsweise Magen, Niere, Leber, Milz oder Gehirn – zuzuordnen. Auf Grund dieser Zuordnung kann das Programm dann die genaue Lage und Form darstellen. „Glücklicherweise hatten wir Zugriff auf mehrere hundert Bilddatensätzen von Mäusen aus einem anderen Forschungsprojekt, die alle bereits von zwei Biologen interpretiert worden waren“, erinnert sich Schoppe. Hinzu kamen fluoreszenzmikroskopische 3D-Scans vom Institut für Tissue Engineering and Regenerative Medicine am Helmholtz Zentrum München.

Den Forschern dort war es mit einer speziellen Technik gelungen, bereits verstorbene Mäuse vollständig zu entfärben. Die transparenten Körper konnten Punkt für Punkt und Schicht für Schicht mit einem Mikroskop abgerastert werden. Die Abstände zwischen den Messpunkten betrugen dabei nur sechs Mikrometer – das entspricht der Größe einer Zelle. Auch in diesen Datensätzen hatten Biologen die Organe lokalisiert.

Am TranslaTUM präsentierten die Informatiker diese Daten ihren neuen Algorithmen. Diese lernten schneller als erwartet, berichtet Schoppe: „Wir haben nur etwa zehn Ganzkörperscans gebraucht, dann konnte die Software die Analyse der Bilddaten allein bewerkstelligen – und zwar innerhalb von Sekunden. Ein Mensch braucht dafür Stunden.“

Die Zuverlässigkeit der Künstlichen Intelligenz überprüfte das Team anschließend mit Hilfe von 200 weiteren Ganzkörper-Scans von Mäusen. „Das Ergebnis zeigt, dass selbstlernende Algorithmen bei der Auswertung biologischer Bilddaten nicht nur schneller, sondern auch treffsicherer sind als der Mensch“, resümiert Prof. Bjoern Menze, Leiter der Image-Based Biomedical Modeling Group am TranslaTUM der Technischen Universität München TUM.

Eingesetzt werden soll die Intelligente Software künftig vor allem in der Grundlagenforschung: „Bildaufnahmen von Mäusen werden dringend benötigt, zum Beispiel um die Wirkweise von neuen Medikamenten zu untersuchen, bevor sie beim Menschen zum Einsatz kommen. Die Auswertung von Bilddaten mit selbstlernenden Algorithmen kann künftig viel Zeit sparen“, betont Menze.

Quelle: Technische Universität München (TUM)

05.01.2021