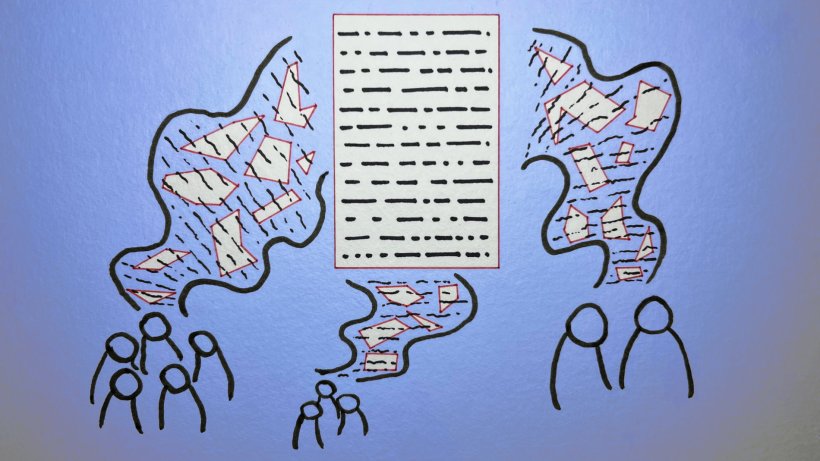

Bildquelle: Yasmine Boudiaf & LOTI / Data Processing als Beitrag zum Workshop 'Better Images of AI' an der Science Gallery London (CC-BY 4.0)

News • KI-generierte Zusammenfassungen

LLMs übertreiben bei wissenschaftlichen Publikationen

Wissenschaftliche Untersuchung von 4.900 generierten Beiträgen zeigt zu weit gefasste Ergebnisse

Zusammenfassungen wissenschaftlicher Arbeiten durch KI-Sprachmodelle wie ChatGPT legen die Ergebnisse äußerst großzügig aus. Ihre Schlussfolgerungen gehen über den tatsächlichen Inhalt der Studien hinaus. In 73% aller Fälle haben das Uwe Peters von der Universität Utrecht sowie Benjamin Chin-Yee von der University of Cambridge und der Western University nachgewiesen. Die Wissenschaftler haben ihre Erkenntnisse im Fachjournal Royal Society Open Science veröffentlicht.

Da Menschen KI-Antworten bevorzugen, die hilfreich und allgemein anwendbar klingen, könnten die Modelle durch Interaktionen lernen, flüssiges Schreiben und Verallgemeinerungen gegenüber Präzision zu bevorzugen

Uwe Peters

Die Forscher haben ChatGPT und DeepSeek getestet und Tausende von Chatbot-generierten Wissenschaftszusammenfassungen analysiert. Ergebnis: Die meisten Modelle liefern durchweg weiter gefasste Schlussfolgerungen als jene, die aus den Texten hervorgehen. Überraschenderweise verschärften Aufforderungen zur Genauigkeit das Problem, und neuere KI-Modelle schnitten schlechter ab als ältere. Bewertet worden ist, wie genau zehn führende Modelle Artikel aus renommierten Wissenschafts- und Medizinzeitschriften wie "Nature", "Science" und "Lancet" zusammenfassen.

Insgesamt wurden 4.900 von den Tools erstellte Texte ausgewertet. Mehr oder weniger übertrieben sie Aussagen aus den Originaltexten, oft auf subtile, aber wirkungsvolle Weise, indem sie beispielsweise vorsichtige Aussagen in der Vergangenheitsform wie "Die Behandlung war in dieser Studie wirksam" in eine pauschalere Aussage in der Gegenwartsform wie "Die Behandlung ist wirksam" umformulierten. Diese Änderungen könnten Leser zur irrigen Annahme verleiten, dass die Ergebnisse viel allgemeiner gültig sind, als dies tatsächlich der Fall ist, so die Warnung.

Dieser Artikel könnte Sie auch interessieren

Artikel • Generative KI in der Medizin

Wie man LLMs beibringt, wie ein Arzt zu denken

Generative KI zeigt zwar immenses Potenzial für das Gesundheitswesen, doch die Zuverlässigkeit der großen Sprachmodelle leidet unter einem ernsten Problem: LLMs denken einfach nicht wie Ärzte, erklärte ein Experte für Datenwissenschaften auf dem Kongress Emerging Technologies in Medicine (ETIM) in Essen. Dieser potenziell folgenschwere Fehler könne jedoch behoben werden.

Peters und Chin-Yee haben in der Folge auch von Chatbots und Menschen generierte Zusammenfassungen derselben Artikel miteinander verglichen. Chatbots neigten fast fünfmal häufiger zu weitreichenden Verallgemeinerungen als ihre menschlichen Kollegen. "Frühere Studien haben gezeigt, dass Überverallgemeinerungen in wissenschaftlichen Texten oft vorkommen. So ist es nicht überraschend, dass Modelle, die mit diesen Texten trainiert wurden, dieses Muster reproduzieren", so Chin-Yee. "Da Menschen KI-Antworten bevorzugen, die hilfreich und allgemein anwendbar klingen, könnten die Modelle durch Interaktionen lernen, flüssiges Schreiben und Verallgemeinerungen gegenüber Präzision zu bevorzugen", erklärt Peters.

Quelle: Utrecht University/pressetext

16.05.2025