News • Künstliche Intelligenz für Hörgeräte

Cochlea-Implantate & Co.: Besser hören mit KI

In lauter Umgebung ist es mit einem Hörgerät oder Hörimplantat schwer, ein Gegenüber zu verstehen, weil derzeitige Audioprozessoren noch Schwierigkeiten haben, sich präzise genug auf bestimmte Schallquellen zu fokussieren. Forschende des Hörforschungslabors der Universität Bern und des Inselspitals zeigen nun in einer Machbarkeitsstudie, dass Künstliche Intelligenz (KI) dieses Problem lösen könnte.

Bildquelle: Unsplash/Jaee Kim

Die Studie ist im Fachjournal Hearing Research veröffentlicht.

Hörgeräte oder Hörimplantate sind aktuell nicht sehr gut darin, für den Träger aus vielen Schallquellen gezielt Sprache herauszufiltern – eine natürliche Fähigkeit unseres Gehirns, die bei gesundem Hören funktioniert und in Fachkreisen als 'Cocktail-Party-Effekt' bezeichnet wird. Entsprechend schwierig ist es für Personen mit Hörhilfen, in lauter Umgebung einer Unterhaltung zu folgen. Forschende des Hörforschungslabors des ARTORG Center, Universität Bern, und des Inselspitals haben nun einen ungewöhnlichen Ansatz erarbeitet, um Hörhilfen in dieser Hinsicht zu verbessern: virtuelle Zusatzmikrofone, deren Signale von einer KI errechnet werden.

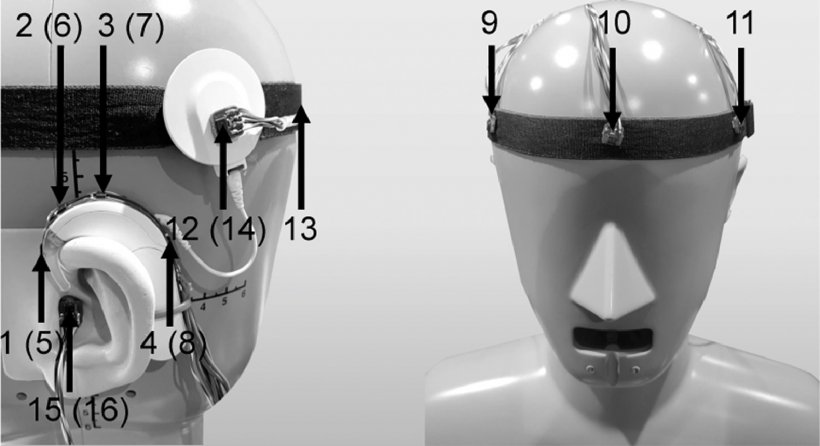

Je mehr Mikrofone ein Audioprozessor zur Verfügung hat und je breiter diese verteilt sind, desto besser kann eine Hörhilfe den Schall aus einer bestimmten Richtung fokussieren. Die meisten Hörgeräte besitzen aus Platzgründen zwei nahe beieinander liegende Mikrofone. Im ersten Teil der Studie hat das Hearing Research Laboratory (HRL) ermittelt, dass die optimale Mikrofon-Position (für eine bessere Fokussierung) mitten auf der Stirn liegt - allerdings eine sehr impraktikable Stelle. "Dieses Problem wollten wir umgehen, indem wir dem Audioprozessors mit künstlicher Intelligenz ein virtuelles Mikrofon hinzufügen," erklärt Tim Fischer, Postdoktorand am HRL, den unkonventionellen Lösungsansatz.

Für den Studienaufbau nutzten die Ingenieure des ARTORG Center den 'Bern Cocktail-Party-Datensatz', eine Sammlung einer Vielzahl von Geräusch-Szenarien mit mehreren Schallquellen aus Multi-Mikrofon-Aufnahmen von Hörgerät- oder Cochlea-Implantat-Trägern. Anhand von 65 Stunden Audioaufnahmen (über 78.000 Audiodateien) trainierten sie ein neuronales Netzwerk zur Verfeinerung eines häufig eingesetzten Richtwirkungs-Algorithmus (Beamforming). Für ein verbessertes Sprachverstehen errechnete der Deep-Learning-Ansatz zusätzliche virtuelle Mikrofon-Signale aus dem Audiodaten-Gemisch. 20 Probanden testeten das KI-verstärkte Hören in einem subjektiven Hörtest, begleitet von objektiven Messungen. Insbesondere in Cocktail-Party-Settings verbesserten die virtuell abgetasteten Mikrofonsignale die Sprachqualität signifikant. Hörgeräte- und Cochlea-Implantat-Nutzer könnten daher besonders in lauten Umgebungen von dem vorgestellten Ansatz profitieren.

Bildquelle: Fischer et al., Hearing Research 2021 (CC BY-NC-ND 4.0)

"Ich denke, dass Künstliche Intelligenz einen wichtigen Beitrag für die nächste Generation von Hörprothesen darstellt, da sie großes Potential für eine Verbesserung des Sprachverstehens, insbesondere in schwierigen Hörsituationen hat," sagt Marco Caversaccio, Chefarzt und HNO-Klinikdirektor. Da auditive Unterstützungs-Technologien und -Implantate zu einem Schwerpunkt der Forschungsarbeit am Inselspital gehören, werden hier wichtige datenbasierte Grundlagen für eine Weiterentwicklung geschaffen, die dem natürlichen Hörerlebnis näher kommen soll. Die neuartigen Ansätze kommen im Rahmen von Translationsstudien direkt den Patienten zugute.

Obwohl die virtuell addierten Mikrofone die Qualität des Sprachverstehens mit Hörhilfe innerhalb dieser Studie deutlich verbesserten, müssen weitere Studien noch einige technische Hürden nehmen, bevor die Methodik in Hörgeräten oder Cochlea-Implantat-Audioprozessoren eingesetzt werden kann. Dazu gehört etwa ein stabil funktionierendes Richtungsverstehen auch in Umgebungen mit einem großen Nachhall.

Quelle: Inselspital, Universitätsspital Bern

30.06.2021